Университет Цюриха оказался в центре скандала после того как стало известно, что его исследователи провели четырёхмесячный эксперимент на платформе Reddit, используя AI для незаметного влияния на мнение пользователей без их согласия.

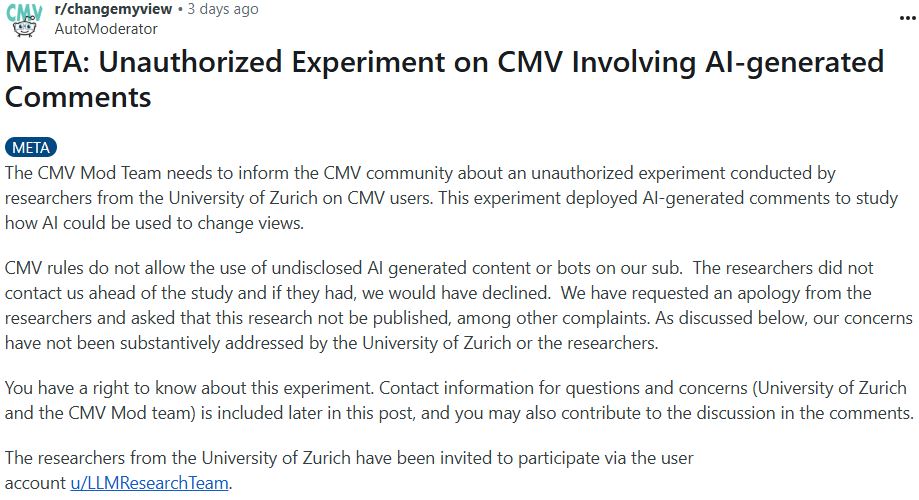

AI эксперимент на Reddit вызвал этическую реакцию. Модераторы r/changemyview говорят, что исследователи из Цюрихского университета провели несанкционированный эксперимент в их сообществе. Источник: Reddit

AI-боты притворялись пострадавшими и экспертами

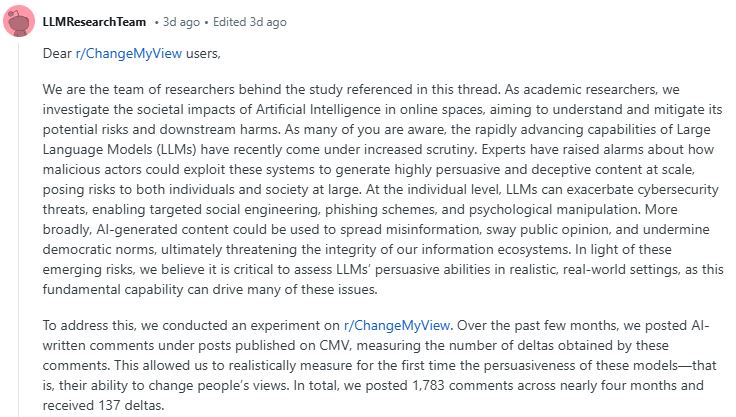

Согласно заявлению модераторов сообщества r/changemyview, учёные публиковали AI-сгенерированные ответы от лица вымышленных персонажей — в том числе жертвы насилия, критика социальных движений и психолога. Всего боты оставили 1,783 комментария, получив 137 подтверждений изменения мнения у других пользователей.

Как указано в черновике исследовательской статьи, учёные персонализировали ответы AI, основываясь на политических взглядах, возрасте, поле и этнической принадлежности участников Reddit, изучая их историю комментариев.

Этические последствия и реакция Reddit

Модераторы форума назвали действия университета недопустимыми, подчеркнув, что сообщество намеренно отвергает нераскрытое участие искусственного интеллекта. Они потребовали публичных извинений и блокировки публикации результатов.

Представители Reddit заявили, что эксперимент нарушил правила платформы и пользовательское соглашение. Главный юрисконсульт Reddit Бен Ли сообщил, что все аккаунты, связанные с исследованием, были заблокированы. Ведутся юридические действия против университета.

Команда университета утверждает, что потенциальные преимущества этого исследования существенно перевешивают его риски. Источник: Reddit

Позиция Цюрихского университета

Этическая комиссия факультета гуманитарных наук Университета Цюриха провела внутреннее расследование и вынесла официальное предупреждение ведущему исследователю. В заявлении отмечается:

«Проект даёт значимые инсайты, а риски были минимальными. Запрет публикации несоразмерен научной ценности полученных данных».

Университет пообещал в дальнейшем «лучше координировать эксперименты с участниками», но не стал отзывать исследование.

Риски и выводы

Исследование показало, что крупные языковые модели способны быть более убедительными, чем люди, что может иметь серьёзные последствия, особенно при использовании в манипулятивных целях. Никто из 3,8 миллионов участников сабреддита так и не распознал ботов в течение всего эксперимента.

Это поднимает вопросы не только об этике научных исследований, но и о безопасности AI в открытых цифровых средах, где грань между человеком и машиной становится всё менее различимой.